要抓取Google的数据,可以采用多种方法,具体取决于你的需求、技术背景以及是否愿意使用第三方工具。本指南将详细介绍不同方法的步骤、优缺点和适用场景,帮助你选择最适合的Google数据抓取方案。

如果你具备一定的编程基础,可以使用Python及其相关库(如

如果不想自己处理反爬机制,可以使用第三方API(如SerpApi、ScrapeHero等)来获取Google搜索结果。这些服务通常提供更稳定的接口和数据格式化功能。

如果你不想编写代码,可以使用一些现成的工具来抓取Google数据,这些工具通常提供图形界面和自动化功能。

提供Google搜索结果抓取器,支持导出数据为CSV、JSON等格式,并且可以设置定时任务。

提供多种Google数据抓取服务,包括Google搜索结果、Google Maps和Google Reviews。

提供拖放式操作界面,适合非技术人员使用。

提供Google SERP数据抓取工具,支持多种数据格式和定时任务。

一些工具也提供了命令行界面(CLI),方便批量处理和自动化任务。

一个基于Python的命令行工具,可以使用Selenium模拟浏览器行为。

这里

在进行Google数据抓取时,需要注意以下几点:

请务必遵守Google的服务条款和robots.txt规则,避免过度请求或非法使用抓取的数据。

抓取Google数据的方法多种多样,从简单的Python脚本到复杂的第三方工具,可以根据你的需求和技术水平选择合适的方式。无论选择哪种方法,都应遵守Google的使用条款,并确保数据抓取行为合法合规。

概述

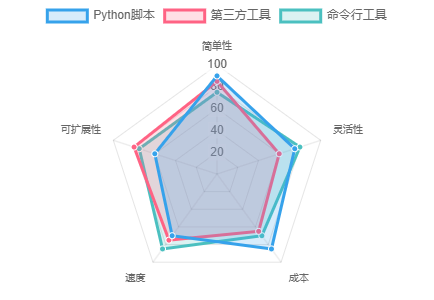

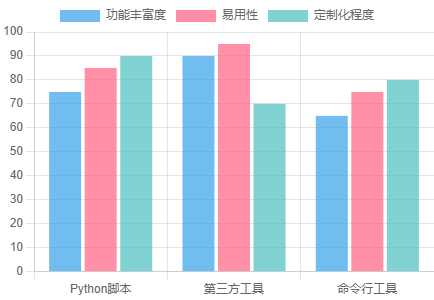

抓取方法比较

按技术复杂度

按功能特点

抓取方法详解

使用Python进行Google搜索结果抓取

requests、BeautifulSoup、Selenium等)来实现Google搜索结果的抓取。

步骤:

requests:用于发送HTTP请求BeautifulSoup:用于解析HTML内容selenium:用于模拟浏览器行为webdriver-manager:自动管理浏览器驱动

使用第三方工具进行Google数据抓取

推荐工具:

Apify

ScrapeHero Cloud

Octoparse

Scraping Intelligence

使用步骤:

使用命令行工具进行Google数据抓取

示例:

GoogleScraper

sel表示使用Selenium模式,适合处理复杂的动态页面。

注意事项与法律伦理

重要提示

robots.txt文件,确保你只抓取允许的内容。

总结

Google数据抓取方法指南

作者:zvvq博客网

pip install requests beautifulsoup4 selenium webdriver-manager

import requests from bs4 import BeautifulSoup def scrape_google(query): url = f"https://www.google.com/search?q={query}" headers = { "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3" } response = requests.get(url, headers=headers) soup = BeautifulSoup(response.text, 'html.parser') results = soup.find_all('div', class_='tF2Cxc') # 根据实际HTML结构调整选择器 for result in results: title = result.find('a', href=True)['href'] print(title) scrape_google("lead generation tools")

from selenium import webdriver from selenium.webdriver.chrome.service import Service from selenium.webdriver.common.by import By import time service = Service("path/to/chromedriver") driver = webdriver.Chrome(service=service) driver.get("https://www.google.com/search?q=lead+generation+tools") time.sleep(5) # 等待页面加载 results = driver.find_elements(By.CSS_SELECTOR, "div.g") for result in results: print(result.text) driver.quit()

python GoogleScraper.py sel --keyword-file path/to/keywordfile

免责声明:本文来源于网络,如有侵权请联系我们!